Die CASA RC Trust Summer School 2025 bietet eine spannende Möglichkeit, sich mit aktuellen Themen rund um Cyber- und Gesellschaftssicherheit im KI-Zeitalter auseinanderzusetzen. Vom 23. bis 27. Juni 2025 findet die Veranstaltung an der Ruhr-Universität Bochum statt – eine perfekte Gelegenheit, um Wissen zu vertiefen, neue Perspektiven zu gewinnen und mit Expertinnen und Experten ins Gespräch zu kommen.

Wer kann mitmachen?

Die Summer School richtet sich an:

- Masterstudierende

- Promovierende

- Postdocs

- Fortgeschrittene Bachelorstudierende kurz vor dem Abschluss

Was erwartet dich?

- Spannende Vorträge und Diskussionen über Cybersicherheit, KI-gesteuerte Bedrohungen und gesellschaftliche Herausforderungen

- Einblicke von führenden Forschenden auf diesem Gebiet

- Interaktive Sessions, die Austausch und Zusammenarbeit fördern

Wie kannst du dich bewerben?

Eine Anmeldung ist nicht mehr möglich.

Gruppenaktivität bei der Summer School 2023. Copyright: CASA/ Meyer

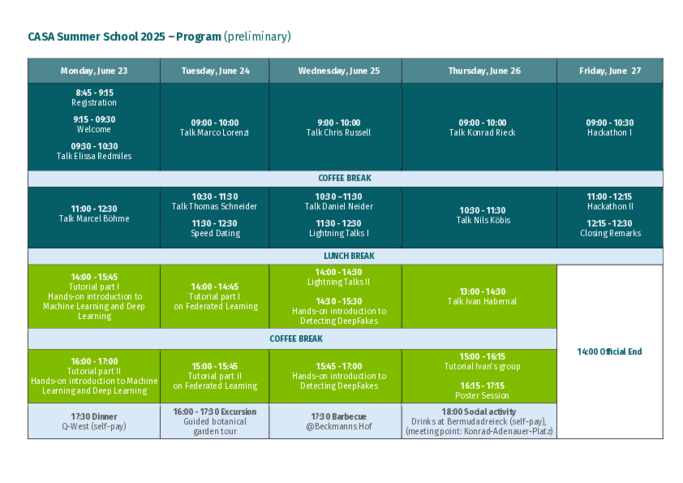

Programm

Speaker*innen

Copyright: privat

Marco Lorenzi

(Centre Inria d’Université Côte d’Azur)

This lecture will illustrate the principles of federated learning with a focus on healthcare applications. We will explore the key challenges associated with the federated learning paradigm, including learning with heterogeneous and incomplete data across clients, requiring the development of unbiased strategies for effective model aggregation. Additionally we will discuss the problem of federated unlearning, which arises when a client wishes to remove their contribution from a jointly trained model, and how this can be effectively achieved without compromising the integrity of the model or revealing sensitive information about the client's data. Specifically we will examine the challenges of identifying and removing the influence of a particular client's data on the global model and explore potential solutions inspired by differential privacy. Finally, we will analyze software solutions available to address these challenges, highlighting the successful implementation of advanced federated analysis systems for multimodal imaging data in the fields of oncology and neuroimaging.

Copyright: privat

Elissa Redmiles

(Georgetown University)

"Safe(r) Digital Intimacy: Lessons for Internet Governance & Digital Safety"

The creators of sexual content face a constellation of unique online risks. In this talk I will review findings from over half a decade of research I've conducted in Europe and the US on the use cases, threat models, and protections needed for intimate content and interactions. We will start by discussing what motivates for the consensual sharing of intimate content in recreation ("sexting") and labor (particularly on OnlyFans, a platform focused on commercial sharing of intimate content). We will then turn to the threat of image-based sexual abuse, a form of sexual violence that encompasses the non-consensual creation and/or sharing of intimate content. We will discuss two forms of image-based sexual abuse: the non-consensual distribution of intimate content that was originally shared consensually and the rising use of AI to create intimate content without people's consent. The talk will conclude with a discussion of how these issues inform broader conversations around internet governance, digital discrimination, and safety-by-design for marginalized and vulnerable groups.

Copyright: privat

Thomas Schneider

(Technical University of Darmstadt)

„Private Machine Learning via Multi-Party Computation"

Privacy-preserving machine learning (PPML) protocols allow to privately evaluate or even train machine learning models on sensitive data while simultaneously protecting the data and the model. In this talk, I will start with some historic works in the rapidly growing field of PPML up to very recent results. Among the several available techniques enabling PPML such as homomorphic encryption, trusted execution environments, differential privacy and Multi-Party Computation (MPC), I will put most emphasis on MPC. The main message and running theme of this presentation will be that PPML is much more than just evaluating or training neural networks under encryption. I will give an overview on a large variety of research works with special focus on those by the ENCRYPTO Group at TU Darmstadt and will conclude with an outlook on future directions in the area of PPML.

Copyright: Fuchs/ TU Berlin

Konrad Rieck

(Technical University Berlin)

“Attacks on Machine Learning Backends”

The security of machine learning is typically discussed in terms of adversarial robustness and data privacy. Yet beneath every learning-based system lies a complex layer of infrastructure: the machine learning backends. These hardware and software components are critical to inference, ranging from GPU accelerators to mathematical libraries. In this talk, we examine the security of these backends and present two novel attacks. The first implants a backdoor in a hardware accelerator, enabling it to alter model predictions without visible changes. The second introduces Chimera examples—a new class of inputs that produce different outputs from the same model depending on the linear algebra backend. Both attacks reveal a natural connection between adversarial learning and systems security, broadening our notion of machine learning security.

Copyright: privat

Marcel Böhme

(MPI-SP)

"Benchmarks are our measure of progress. Or are they?"

How do we know how well our tool solves a problem, like bug finding, compared to other state-of-the-art tools? We run a benchmark. We choose a few representative instances of the problem, define a reasonable measure of success, and identify and mitigate various threats to validity. Finally, we implement (or reuse) a benchmarking framework, and compare the results for our tool with those for the state-of-the-art. For many important software engineering problems, we have seen new sparks of interest and serious progress made whenever a (substantially better) benchmark became available. Benchmarks are our measure of progress. Without them, we have no empirical support to our claims of effectiveness. Yet, time and again, we see practitioners disregard entire technologies as "paper-ware"---far from solving the problem they set out to solve. In this keynote, I will discuss our recent efforts to systematically study the degree to which our evaluation methodologies allow us to measure those capabilities that we aim to measure. We shed new light on a long-standing dispute about code coverage as a measure of testing effectiveness, explore the impact of the specific benchmark configuration on the evaluation outcome, and call into question the actual versus measured progress of an entire field (ML4VD) just as it gains substantial momentum and interest.

Copyright: University of Oxford

Chris Russel

(University of Oxford)

"AGI: Artificial Good-enough Intelligence?"

Much of the recent work in the governance of AI treats LLMs as a precursor to a superhuman general intelligence and focuses on mitigating the harms that such intelligences could provide. Instead, we look at LLMs as they are now, and ask: where can they be used in their current form; what harms can arise from their use; and what can we do to improve their behaviour.

Copyright: RUB, Marquard

Ivan Habernal

(Research Center Trustworthy Data Science and Security)

"A concise introduction to privacy-preserving natural language processing"

In this lecture and tutorial we will address some fundamental techniques for protecting privacy in the field of natural language processing. We will start with some philosophical thoughts on what privacy and secrets are, continue with ad-hoc techniques for text anonymization, and look into formal probabilistic treatment relying on the framework of differential privacy for protecting training data of neural networks. We will finish with some open fundamental questions, so you can spend the rest of the day wrapping your head around them. In the hands-on tutorial, we will touch the surface with some tools for

privacy-preserving NLP, mostly in the realm of Python and neural nets.

Copyright: RC Trust

Nils Koebis

(Research Center Trustworthy Data Science and Security)

"How Artificial Intelligence influences Human Ethical Behavior"

As machines powered by artificial intelligence (AI) influence humans’ behavior in ways that are both like and unlike the ways humans influence each other, worry emerges about the corrupting power of AI agents.

Dealing with this emerging worry, in this talk, I will present a short overview of the available evidence from behavioral science, human-computer interaction, and AI research on how AI influences human ethical behavior and how psychological science can help to mitigate these new risks.

As a theoretical contribution, I propose a conceptual framework that outlines four main social roles through which machines can influence ethical behavior. These are role models, advisors, partners, and delegates1.

As empirical contributions, I present recently published and unpublished experimental work testing the roles of advisors and delegates. These results (stemming from > N = 9,000 participants) show that (a) when AI agents are moral advisors, their corrupting power matches that of humans2, (b) when they assist people in lie detection, they massively increase accusation rates3, and (c) when AI agents become delegates, people willingly delegate unethical behavior to them – although the interface through which people delegate plays a big role too4.

As a policy contribution, the talk will conclude by summarizing behavioral insights testing, which commonly proposed interventions (e.g., in the most recent proposal for the EU AI ACT) successfully mitigate the risks of AI corrupting ethical behavior5 and sketch an agenda for interdisciplinary behavioral AI safety research.

1 - Köbis, N., Bonnefon, J. F., & Rahwan, I. (2021). Bad machines corrupt good morals. Nature Human Behaviour, 5(6), 679-685.

2 - *Leib, M., *Köbis, N., Rilke, R. M., Hagens, M., & Irlenbusch, B. (2024). Corrupted by algorithms? how ai-generated and human-written advice shape (dis) honesty. The Economic Journal, 134(658), 766-784.

3 - von Schenk, A., Klockmann, V., Bonnefon, J. F., Rahwan, I., & Köbis, N. (2024). Lie detection algorithms disrupt the social dynamics of accusation behavior. iScience, 27(7).

4 - *Köbis, *Rahwan, Ajaj, Bersch, Bonnefon, & Rahwan (Working Paper) Experimental evidence that delegating to intelligent machines can increase dishonest behaviour.

5 - Köbis, N., Starke, C., & Rahwan, I. (2022). The promise and perils of using artificial intelligence to fight corruption. Nature Machine Intelligence, 4(5), 418-424.

Copyright: RC Trust

Daniel Neider

(Research Center Trustworthy Data Science and Security)

"A gentle Introduction to Neural Network Verification"

Artificial Intelligence has become ubiquitous in modern life. This "Cambrian explosion" of intelligent systems has been made possible by extraordinary advances in machine learning, especially in training deep neural networks and their ingenious architectures. However, like traditional hardware and software, neural networks often have defects, which are notoriously difficult to detect and correct. Consequently, deploying them in safety-critical settings remains a substantial challenge. Motivated by the success of formal methods in establishing the reliability of safety-critical hardware and software, numerous formal verification techniques for deep neural networks have emerged recently. These techniques aim to ensure the safety of AI systems by detecting potential bugs, including those that may arise from unseen data not present in the training or test datasets, and proving the absence of critical errors. As a guide through the vibrant and rapidly evolving field of neural network verification, this talk will give an overview of the fundamentals and core concepts of the field, discuss prototypical examples of various existing verification approaches, and showcase state-of-the-art tools.

Veranstaltungsort

Die Summer School 2025 hat zwei Veranstaltungsorte. Beide befinden sich auf dem Campus der Ruhr-Universität Bochum.

An den Tagen 1-4 (23. bis 26. Juni) findet die Summer School im Veranstaltungszentrum der RUB statt. Wegbeschreibung zum Veranstaltungszentrum mit ÖPNV und mit Auto.

Veranstaltungzentrum, Ebene 04, Saal 3

Universitätsstraße 150

44801 Bochum

Am letzten Tag (27. Juni) findet die Summer School im Beckmanns Hof statt. Wegbeschreibung zum Beckmanns Hof mit ÖPNV und mit Auto.

Beckmanns Hof

Universitätsstraße 150

44801 Bochum

Program Chairs

Rückblicke auf vergangene Summer Schools

Summer School crypt@b-it 2024

Praxisorientierte Ansätze sind in der Wissenschaft von entscheidender Bedeutung – und genau darauf lag der Schwerpunkt der diesjährigen Summer School crypt@b-it 2024. Vom 26. bis 30. August kamen Nachwuchswissenschaftler*innen im Tagungszentrum "Beckmanns Hof" der Ruhr-Universität Bochum zusammen, um die verschiedene Themen aus der Kryptographie zu diskutieren.

Zu den Speaker*innen zählten Prof. Léo Ducas (Leiden University), Anca Nitulescu (Input Output Global, Paris) und Maximilian Gebhardt (Bundesamt für Sicherheit in der Informationstechnik, BSI). Die Veranstaltung wurde von der Gesellschaft für Informatik (GI), Fachgruppe Kryptologie (FG Krypto), CASA und b-it (Bonn-Aachen International Center for Information Technology) in Zusammenarbeit mit der International Association for Cryptologic Research (IACR) organisiert.

Rückblick: CASA Summer School 2023 zum Thema Software Security

Kreativität wird in der Wissenschaft immer gefordert – und wurde in der diesjährigen CASA Summer School on Software Security in vielerlei Hinsicht gefördert. Das dreitägige Event fand vom 14. - 16.8.2023 im Tagungszentrum Beckmanns Hof der Ruhr-Universität Bochum (RUB) unter der Leitung der CASA PIs Prof. Kevin Borgolte, Prof. Marcel Böhme und Prof. Alena Naiakshina statt.

Das Programm beinhaltete dabei nicht nur klassische Talks, bei denen internationale Speaker*innen spannende Einblicke in ihre Forschung gaben. Mit einem Capture the Flag Contest, einem Science Escape Game und einem Summer Pitch konnten die Teilnehmer*innen sich auch in spielerischer Art und Weise mit der Thematik auseinandersetzen.

Zu Gast in Bochum waren dafür Prof. Eric Bodden (Heinz Nixdorf Institut an der Universität Paderborn und Fraunhofer IEM), Prof. Helen Sharp (The Open University), Prof. Fish Wang (Arizona State University), Prof. Andreas Zeller (CISPA Helmholtz Center for Information Security) und Prof. Verena Zimmermann (ETH Zürich). Außerdem gaben Dr. Tamara Lopez (The Open University) und Fabian Schiebel (Fraunhofer-Institut für Entwurfstechnik Mechatronik IEM) begleitenden Tutorials.

Vielfältige und ansprechende Präsentationen

Den Start in das Programm der Summer School machte dabei Helen Sharp, die eine Keynote zum Thema "Secure code development in practice: the developers’ point of view" hielt. Im weiteren Verlauf des ersten Tages stand der Faktor Mensch in der Cybersicherheit ebenfalls im Fokus: In ihrer Keynote "Human-Centered Security: Focusing on the human in IT security and privacy research" reflektiere Verena Zimmermann unter anderem die psychologischen Aspekte der Cybersicherheit und deren Einbezug ins Design von Usable Security and Privacy Solutions. Am zweiten Tag erhielten die Teilnehmer*innen spannende Einblicke in das Thema "Language Based Fuzzing", über das Andreas Zeller vom CISPA einen Vortrag hielt. Eric Bodden stellte in seiner Keynote seine Forschung zu "Managing the Dependency Hell - Challenges and Current Approaches to Software Composition Analysis" vor und sorgte damit für ein tiefergehendes Verständnis in den Fachbereich.

"Für mich war die CASA Summer School aufgrund der vielfältigen und ansprechenden Präsentationen und Tutorials exzellenter Forscher*innen sowie der aktiven Interaktion hochqualifizierter und motivierter Teilnehmer*innen eine erfolgreiche Veranstaltung", resümiert Alena Naiakshina. Summer Schools seien aus ihrer Sicht immer eine gute Möglichkeit für Nachwuchswissenschaftler*innen, führende Expert*innen auf ihrem jeweiligen Gebiet kennen zu lernen sowie interdisziplinäre Perspektiven und die Entwicklung neuer Ideen zu fördern.

Security Exit Game für spielerischen Zugang

Damit Ideen überhaupt entstehen, bedarf es kreativer Wege – wie beispielsweise der spielerische Ansatz eines kartenbasierten Security Exit Games, den Speakerin Verena Zimmermann von der ETH Zürich vorstellte. Das Spiel ist Teil eines Forschungsprojekts, an dem Zimmermann mit der Studentin Linda Fanconi arbeitet. "Verschiedene Studien haben gezeigt, dass Menschen das Thema Cybersecurity zwar wichtig finden, aber es auf der anderen Seite mit vielen negativen Assoziationen behaftet ist: zu komplex, mitunter angsteinflössend, und gleichzeitig zu langweilig. Wir haben das Spiel entwickelt, um den Menschen einen positiven Zugang zum Thema zu ermöglichen." Bei der Summer School ist dieser Plan aufgegangen: Mit sichtlicher Freude erprobten die Teilnehmer*innen das Spiel in kleinen Gruppen und setzten sich so praktisch mit Fragen des Fachgebiets Human Centred Security auseinandersetzen.

Entspannte Atmosphäre und Gelegenheit zum Netzwerken

Neben der Mischung aus verschiedenen fachlichen Themen der hochrangingen Speaker wie Testing, Fuzzing und Developer-Centered Security habe auch der Beckmannshof als Veranstaltungsort zu den positiven Erfahrungen der Teilnehmenden beigetragen, meint Naiakshina. Auch Teilnehmer Kushal Ramkumar vom University College Dublin ist von der Themenvielfalt angetan: "Die CASA Summer School ist sehr gut organisiert und ich habe sehr viel über Themen erfahren, die ich vorher nicht so gut kannte".

Ob beim abendlichen BBQ oder bei der Führung durch den angrenzenden Botanischen Garten: In entspannter Atmosphäre gab es viel Gelegenheit zum Netzwerken. "Veranstaltungen wie die Summer School sind für mich sehr wichtig, um mich auf dem neuesten Stand der Forschung zu halten. Natürlich kann man viel aus der Literatur lernen, aber in einem Rahmen wie diesem kann man direkt mit den Autor*innen sprechen und ihre Gedanken zu einem Thema erfahren. Diese Gespräche können zu interessanten Kooperationen führen und auch neue Perspektiven für meine eigene Forschung eröffnen", sagt Kushal Ramkumar.

Copyright: CASA

Copyright: CASA, Mareen Meyer

Wissenschaftliches Koordinationsteam, Copyright: CASA, Mareen Meyer

Eindrücke von der CASA Summer School 2023

Copyright: CASA, Mareen Meyer

Copyright: CASA, Mareen Meyer

Copyright: CASA, Mareen Meyer

CASA Summer School 2022 zum Thema Blockchain Security

Die CASA Summer School 2022 fand vom 20.-23. Juni im Tagungszentrum Beckmannshof an der Ruhr-Universität Bochum (RUB) statt. Im Fokus der Veranstaltung stand das Thema „Blockchain Security“. Die rund 40 Teilnehmer*innen konnten dabei nicht nur spannenden Vorträgen folgen, sondern die Inhalte in Hands-On-Sessions in der Gruppe erarbeiten und die Gelegenheit zum Netzwerken nutzen.

Sprecher*innen der Summer School waren unter anderem Elli Androulaki (IBM Research), Ghassan Karame (CASA), Lucas Davi (Universität Duisburg-Essen) und Clara Schneidewind (Max-Planck-Institut für Sicherheit und Privatsphäre).

Die ausführliche Nachberichterstattung finden Sie hier.

Copyright: CASA, Fabian Riediger

Eindrücke von der CASA Summer School 2022

Ghassan Karame on Bitcoin Security. Copyright: CASA, Fabian Riediger

Copyright: CASA, Fabian Riediger

Teilnehmer*innen der CASA Summer School 22. Copyright: CASA, Fabian Riediger

Ansprechpartnerin

Johanna Luttermann

CASA Graduate School

(0)234-32-29230

Johanna.Luttermann(at)rub.de